Adobe bündelt zur MAX 2025 seine KI-Entwicklungen so eng mit den Creative-Cloud-Programmen, dass sich der fotografische Workflow von der Sichtung bis zur Ausspielung spürbar verschlankt.

Firefly wächst zum Produktionsstudio, das Ideenfindung, Bild-, Audio- und Videowerkzeuge sowie eine kanalübergreifende Veröffentlichung vereint; parallel ziehen dialogbasierte Assistenten in Express, Firefly und Photoshop ein, die Klartext-Anweisungen in konkrete Arbeitsschritte übersetzen. Für Fotografen bedeutet das weniger Handarbeit an repetitiven Aufgaben und mehr Kontrolle in genau den Momenten, in denen es auf Präzision ankommt.

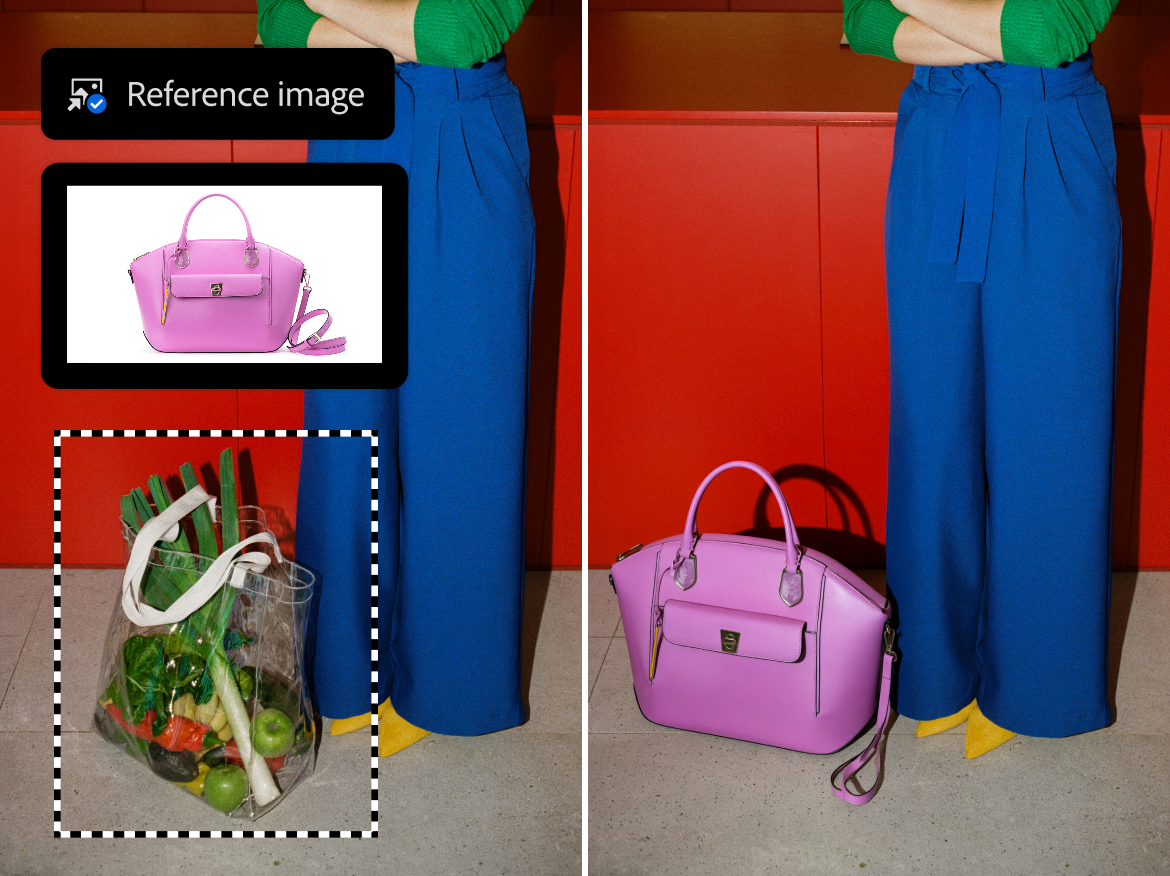

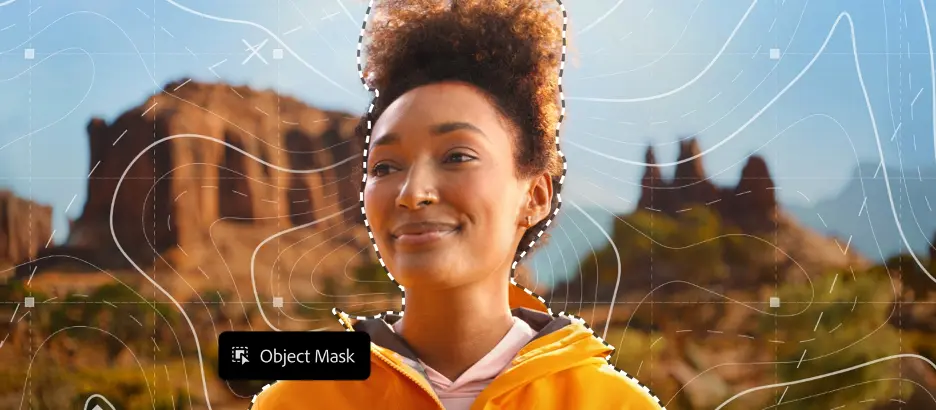

In Lightroom sortiert „Assisted Culling“ große Serien vor und setzt damit dort an, wo bei Hochzeiten, Events oder Sport traditionell die meiste Zeit verloren geht. Gesichterkennung, Schärfe- und Blickprüfung liefern eine belastbare Vorauswahl, die anschließend manuell verifiziert wird. In Photoshop kombinieren Generatives Füllen, Harmonize und das Topaz-gestützte Generative Upscale die gewohnte Werkzeugtiefe mit KI-Komfort: Störendes verschwindet ohne komplexes Maskieren, Ebenen fügen sich farblich und lichtseitig stimmig zusammen, und Dateien lassen sich verlustarm für große Prints oder Messeflächen hochziehen. Für Serien, die konsistent aussehen müssen, bietet „Firefly Creative Production“ eine Batch-Ebene, mit der Hintergründe, Crops und Farbwelten in hunderten Dateien in einem Rutsch angeglichen werden, ohne dass Skriptingkenntnisse nötig wären.

Bemerkenswert ist die Modellfreiheit. Neben Adobes kommerziell kuratierten Firefly-Modellen lassen sich ausgewählte Modelle von Partnern wie Google, OpenAI, Runway, Luma, Black Forest Labs sowie neu ElevenLabs und Topaz in der Adobe-Umgebung nutzen. Das erlaubt die Entscheidung „Look oder Risiko“ je nach Auftragsszenario: Firefly dort, wo Compliance-Sicherheit und kalkulierbare Ergebnisse zählen, Partner-Modelle, wenn es um spezifische Ästhetiken oder Spezialfunktionen geht. Einen Schritt weiter gehen „Firefly Custom Models“ (private Beta), die auf rechtlich sauberen Referenzassets der eigenen Arbeit trainiert werden. Für Layout-Vorschauen, Set-Previews oder Moodboards entsteht so ein Generator, der sich an der eigenen Handschrift orientiert, ohne sie jedes Mal neu bauen zu müssen. Voraussetzung sind klare Rechteketten und, sofern Personen erkennbar sind, entsprechend erweiterte Model-Freigaben.

Der praktische Nutzen zeigt sich in einem einfachen Ablauf: Nach dem Import läuft die KI-gestützte Vorauswahl, die A-Auswahl wird händisch bestätigt, der Grundlook per Preset vereinheitlicht. Kleine Störungen beseitigt Generatives Füllen, Composings werden mit Harmonize plausibel gemacht, und große Sets gehen durch die Batch-Strecke von Firefly. Abschließend folgt der Export für Web und Print; wo KI realistisch in die Bildaussage eingegriffen hat, empfiehlt sich ein transparenter Hinweis in Caption und Metadaten sowie, wenn verfügbar, das Mitschreiben von Content Credentials. Die Kombination aus Tempo-Gewinn und konsistenter Qualität ist der Mehrwert, der in engen Timings, bei umfangreichen Serienproduktionen und in kundenseitigen Freigabeprozessen sofort ankommt.

Für die tägliche Arbeit heißt das: weniger Fummelei an Masken, mehr Zeit für Auswahl, Sequenz, Narrativ und Ausgabequalität. Studios und Einzelkämpfer können Varianten schneller liefern, Styleguides verlässlicher einhalten und Produktionsrisiken durch stabile, wiederholbare Abläufe senken. Gleichzeitig bleibt die Verantwortung fotografisch: Dokumentarische Kontexte sollten zurückhaltend bearbeitet werden, während inszenierte Arbeiten den kreativen Spielraum der neuen Werkzeuge ausschöpfen können. Die MAX 2025 markiert damit keinen Bruch mit der Fotografie, sondern eine Verschiebung der Energie dorthin, wo Autorenschaft sichtbar wird – in Entscheidungen statt in Routine.